支持向量机

1、什么是支持向量机(SVM)?它主要用于解决什么类型的问题?

支持向量机(Support Vector Machine,SVM)是一种强大的监督学习算法,主要用于分类和回归问题。SVM的核心思想是寻找一个最优的超平面或决策边界,以最大化不同类别数据点之间的间隔,并尽量避免误分类。

1. 线性SVM(Linear SVM)

考虑一个二元分类问题,其中我们有一个训练数据集,每个数据点都有一组特征 $X$ 和一个标签 $y$,其中 $y$ 可以是1或-1(或任何两个不同的类别)。我们的目标是找到一个超平面,可以表示为:

$$

w \cdot x + b = 0

$$

其中,$w$ 是法向量(权重向量),$b$ 是截距,$x$ 是输入特征向量。超平面将特征空间分为两个区域,一个表示正类别,另一个表示负类别。

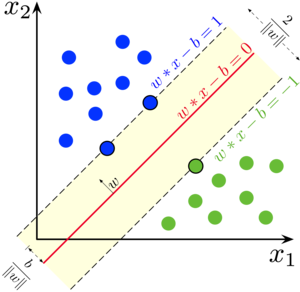

2. 支持向量(Support Vectors)

支持向量是训练数据中距离超平面最近的数据点。它们是用于定义分类间隔(Margin)的关键元素。分类间隔是指超平面与最近的支持向量之间的距离。

3. 最大化间隔(Maximizing Margin)

SVM 的关键目标是找到一个超平面,使得分类间隔最大化。分类间隔的计算如下:

$$

\text{Margin} = \frac{2}{|w|}

$$

其中,$|w|$ 表示权重向量 $w$ 的范数。

4. SVM的优化问题

线性SVM的优化问题可以形式化为以下凸优化问题。

最小化目标函数:

$$

\frac{1}{2} |w|^2

$$

在满足以下约束条件的情况下:

$$

\begin{align*}

y_i(w \cdot x_i + b) \geq 1, & \quad \text{对于所有样本 } i \\

y_i \in \{-1, 1\}, & \quad \text{样本标签}

\end{align*}

$$

这个优化问题的目标是最小化权重向量 $w$ 的范数,以最大化分类间隔,同时确保所有样本都位于分类间隔以外。

5. 核函数(Kernel Function):

SVM 也可以应用于非线性分类问题,通过引入核函数来将数据映射到高维特征空间,从而在高维空间中找到线性可分的超平面。常见的核函数包括线性核、多项式核和径向基函数(RBF)核。

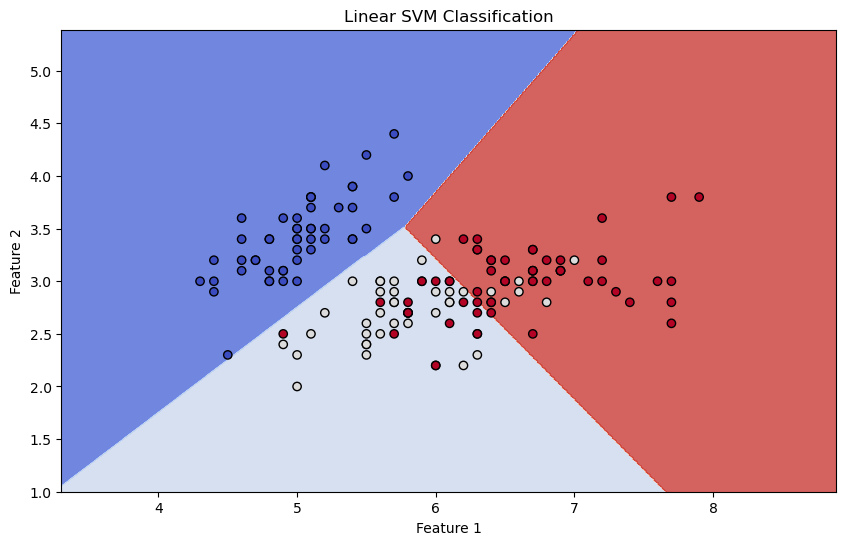

以下是一个使用Scikit-Learn库的线性SVM分类示例,以及相应的可视化:

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn import svm

# 加载示例数据集(鸢尾花数据集)

iris = datasets.load_iris()

X, y = iris.data, iris.target

# 仅使用前两个特征,以便可视化

X = X[:, :2]

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建线性SVM分类器

clf = svm.SVC(kernel='linear')

# 训练模型

clf.fit(X_train, y_train)

# 使用模型进行预测

y_pred = clf.predict(X_test)

# 可视化分类结果

plt.figure(figsize=(10, 6))

# 绘制决策边界

xx, yy = np.meshgrid(np.arange(X[:, 0].min() - 1, X[:, 0].max() + 1, 0.01),

np.arange(X[:, 1].min() - 1, X[:, 1].max() + 1, 0.01))

Z = clf.predict(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

plt.contourf(xx, yy, Z, cmap=plt.cm.coolwarm, alpha=0.8)

# 绘制数据点

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.coolwarm, edgecolors='k')

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.title('Linear SVM Classification')

plt.show()

上述示例中,我们加载了鸢尾花数据集,并仅使用前两个特征以便可视化。然后,我们创建了一个线性SVM分类器,训练模型,并使用模型进行分类。最后,我们通过绘制决策边界和数据点来可视化分类结果。

2、SVM的基本原理是什么?它如何在分类和回归任务中工作?

支持向量机(SVM)的基本原理是在特征空间中找到一个超平面(或决策边界),该超平面可以最大化不同类别数据点之间的间隔,同时尽量避免误分类。

SVM的工作原理在分类和回归任务中有所不同:

在分类任务中

1、SVM的目标是找到一个超平面,将数据点分为两个不同的类别,使得分类间隔(Margin)最大化。

2、Margin是指超平面与最近的支持向量之间的距离,即两个平行超平面之间的距离。

3、支持向量是离超平面最近的数据点,它们对定义分类间隔非常重要。

4、SVM分类器尝试最小化目标函数,该函数包括最小化权重向量的范数以及使每个数据点都位于正确的一侧(根据类别标签)的约束条件。

5、对于非线性数据,可以使用核函数来将数据映射到高维空间,以使数据在高维空间中线性可分。

下面是一个使用Scikit-Learn库的SVM分类示例:

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn import svm

from sklearn.metrics import accuracy_score

# 加载示例数据集(这里使用鸢尾花数据集)

iris = datasets.load_iris()

X, y = iris.data, iris.target

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建线性SVM分类器

clf = svm.SVC(kernel='linear')

# 训练模型

clf.fit(X_train, y_train)

# 使用模型进行预测

y_pred = clf.predict(X_test)

# 评估模型性能

accuracy = accuracy_score(y_test, y_pred)

print("Accuracy:", accuracy)

在回归任务中

1、SVM回归的目标是找到一个超平面,使得数据点尽量接近超平面,同时在一定容忍度内。

2、在回归问题中,SVM的目标是最小化一个损失函数,损失函数衡量了数据点离超平面的距离以及容忍度的违规情况。

3、容忍度(Tolerance)是一个控制在训练期间允许数据点距离超平面的程度的参数。

下面是一个使用Scikit-Learn库的 SVM 回归示例:

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn import svm

from sklearn.metrics import mean_squared_error

# 加载示例数据集(这里使用波士顿房价数据集)

boston = datasets.load_boston()

X, y = boston.data, boston.target

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 创建线性SVM回归模型

clf = svm.SVR(kernel='linear')

# 训练模型

clf.fit(X_train, y_train)

# 使用模型进行预测

y_pred = clf.predict(X_test)

# 评估模型性能

mse = mean_squared_error(y_test, y_pred)

print("Mean Squared Error:", mse)

这个示例展示了SVM在回归问题中的应用,使用了波士顿房价数据集。

3、SVM中的超平面是什么?它如何用于二元分类问题的决策?

SVM中的超平面是一个数学概念,它是用于分割特征空间以执行二元分类的关键元素。超平面是一个维数比特征空间低一的线性子空间。在二元分类问题中,SVM的目标是找到一个超平面,可以将数据点分为两个不同的类别,并且在最大程度上使分类间隔(Margin)最大化。

以下是超平面的概念和用于二元分类的决策过程:

超平面的定义: 对于一个$d$维特征空间,一个超平面可以表示为:

$$

w \cdot x + b = 0

$$

其中,$w$ 是法向量(权重向量)的权重,$b$ 是超平面的偏移(截距),$x$ 是 $d$ 维输入特征向量。超平面将特征空间分为两个部分,一个表示正类别,另一个表示负类别。

SVM的决策规则: 在二元分类中,SVM的决策规则基于超平面上的点 $w \cdot x + b$ 的符号:

- 如果 $w \cdot x + b > 0$,则数据点 $x$ 被分类为正类别(标签为+1)。

- 如果 $w \cdot x + b < 0$,则数据点 $x$ 被分类为负类别(标签为-1)。

最大化间隔: SVM的目标是选择一个超平面,以最大化分类间隔(Margin)。分类间隔是指超平面与最近的训练样本点之间的距离。最大化分类间隔可以增加模型的鲁棒性,使其对新数据的泛化性能更好。

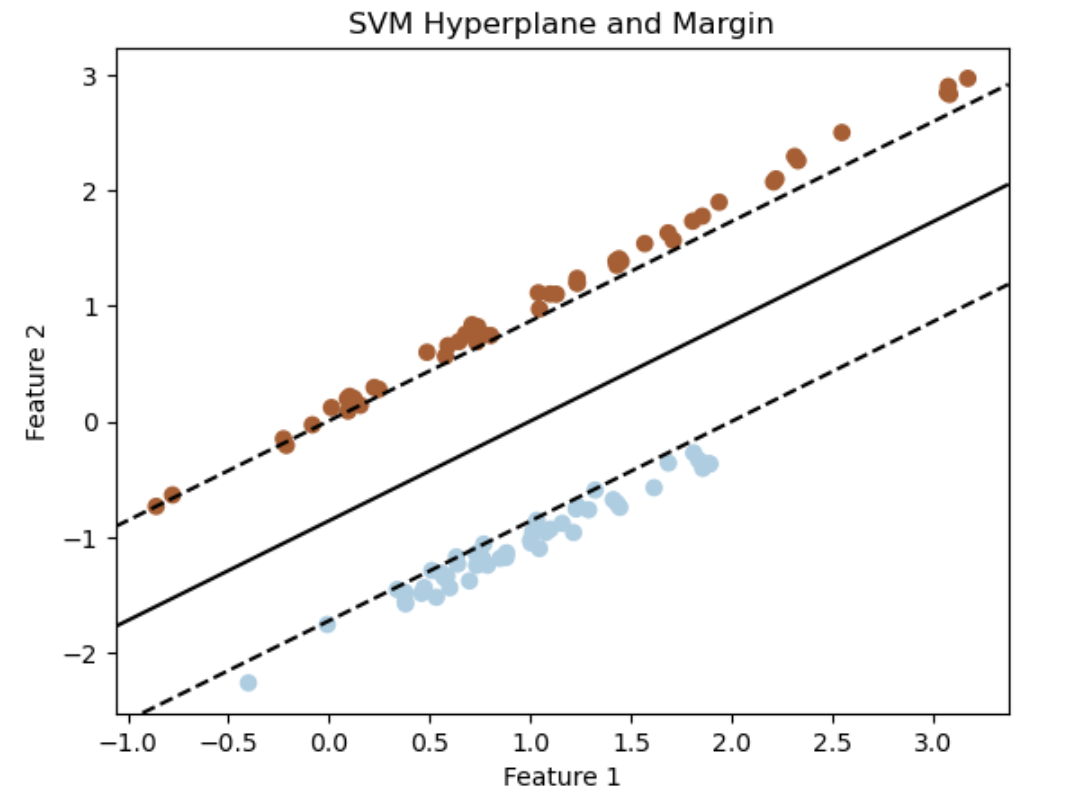

使用 Scikit-Learn 绘制超平面以及如何使用它来进行二元分类决策:

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

from sklearn import svm

# 创建示例数据集(这里使用线性可分的数据)

X, y = datasets.make_classification(n_samples=100, n_features=2, n_informative=2, n_redundant=0, n_clusters_per_class=1, random_state=42)

# 创建线性SVM分类器

clf = svm.SVC(kernel='linear')

# 训练模型

clf.fit(X, y)

# 绘制数据点

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.Paired)

# 绘制超平面

ax = plt.gca()

xlim = ax.get_xlim()

ylim = ax.get_ylim()

# 创建网格来评估模型

xx, yy = np.meshgrid(np.linspace(xlim[0], xlim[1], 50), np.linspace(ylim[0], ylim[1], 50))

Z = clf.decision_function(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

# 绘制超平面和间隔

ax.contour(xx, yy, Z, colors=['k', 'k', 'k'], linestyles=['--', '-', '--'],

levels=[-1, 0, 1])

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.title('SVM Hyperplane and Margin')

plt.show()

这个示例创建了一个线性可分的数据集,训练了一个线性SVM分类器,并绘制了数据点以及超平面和分类间隔。超平面是黑色实线,分类间隔由黑色虚线表示。

演示了如何使用SVM的超平面进行二元分类决策,并且可视化了超平面及其分类间隔。

4、什么是软间隔(Soft Margin)和硬间隔(Hard Margin)SVM?它们有什么区别和应用场景?

软间隔 和硬间隔SVM 是SVM模型的两种变体,它们的主要区别在于对数据的容忍度和对异常点的处理。

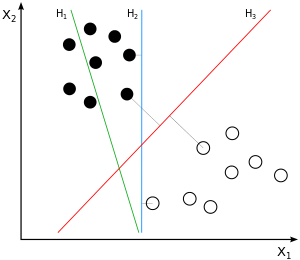

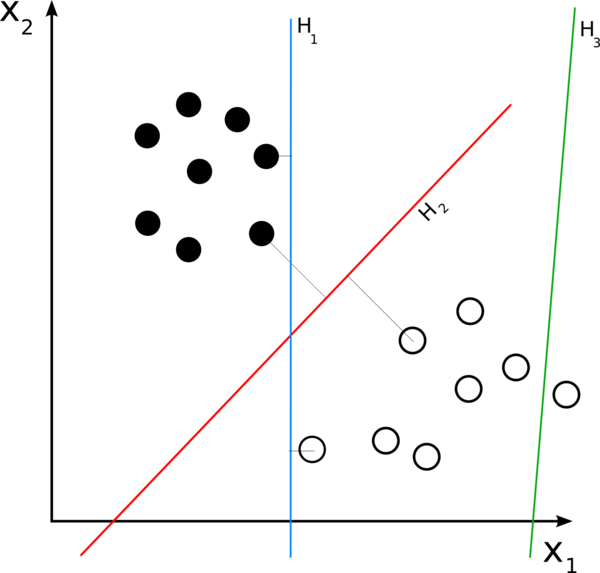

硬间隔SVM

1、硬间隔SVM旨在找到一个完全将训练数据分开的超平面,其中没有训练数据点位于分类间隔内部。

2、在硬间隔SVM中,数据点必须严格满足线性可分的条件,这意味着数据必须严格位于正确的一侧,不允许任何分类错误。

3、硬间隔SVM对异常点非常敏感,即使一个异常点出现在训练数据中,都可能导致无法找到满足条件的超平面。

硬间隔SVM的示意图如下,其中红色和蓝色点表示不同类别的数据,绿色线表示超平面,它严格分开了两个类别的数据:

软间隔SVM

1、软间隔SVM引入了容忍度(Tolerance)的概念,允许一些数据点位于分类间隔内部或甚至被错误分类,以提高模型的鲁棒性。

2、软间隔SVM的目标是找到一个超平面,尽量最大化分类间隔,同时限制分类错误或间隔内部的数据点数量。

3、软间隔SVM更加鲁棒,能够处理一些噪声或异常点,不需要严格满足线性可分条件。

软间隔SVM的示意图如下,其中部分异常点(圆圈)位于分类间隔内部,但模型仍然能够找到一个满足条件的超平面:

应用场景:

– 硬间隔SVM: 适用于数据集严格线性可分的情况,当我们有信心数据不包含异常点或噪声时。

– 软间隔SVM: 更加鲁棒,适用于数据集可能包含一些异常点、噪声或不严格线性可分的情况,允许一定程度的分类错误或数据点位于分类间隔内。

通常,软间隔SVM是更实际的选择,因为它在处理现实世界的数据时更加健壮。硬间隔SVM通常在理论研究中用于分析和证明,而在实际应用中,软间隔SVM更常见。

5、在SVM中,如何处理非线性可分的数据?核函数(Kernel Function)的作用和常用类型。

在SVM中处理非线性可分的数据时,通常使用核函数(Kernel Function)来将数据映射到一个高维特征空间,使得数据在这个高维空间中变得线性可分。

核函数的作用是计算两个数据点之间的相似度或内积,而不需要显式地将数据映射到高维空间。以下是一些常用的核函数及其作用:

1、线性核函数(Linear Kernel)

这是SVM的默认核函数,它在原始特征空间中计算数据点之间的线性关系。适用于线性可分的数据。

2、多项式核函数(Polynomial Kernel):

多项式核函数通过引入多项式项将数据映射到高维空间,使其变得更容易分离。它有一个参数d,表示多项式的阶数。

3、高斯径向基核函数(Gaussian Radial Basis Function Kernel):

高斯核函数通过计算数据点之间的相似度来将数据映射到无限维的高维空间。它有一个参数σ,控制了特征映射的“宽度”。

4、Sigmoid核函数(Sigmoid Kernel):

Sigmoid核函数将数据映射到高维空间,类似于神经网络的激活函数。它在某些特定应用中有用,但不如高斯核函数和多项式核函数常用。

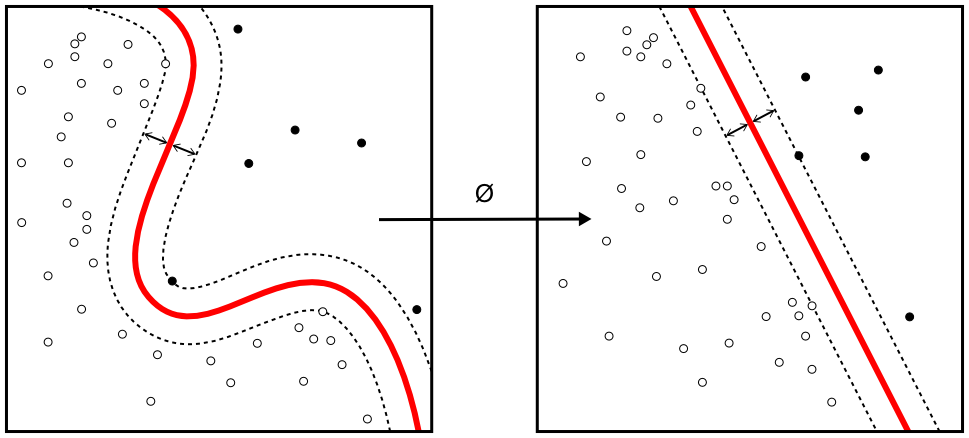

下面是一个示意图,说明如何使用核函数处理非线性可分的数据:

在这个图中,左侧是原始特征空间中的数据点,它们不能被单个超平面分开。右侧是使用核函数将数据映射到高维空间后的结果。在高维空间中,数据点变得线性可分,可以找到一个超平面(这里是一条直线)来分隔它们。

这个示意图展示了核函数如何改变数据的表示,使得原本在低维度中难以处理的非线性可分问题变得容易处理。核函数的选择通常取决于数据的性质和具体问题,需要根据实际情况进行调优。

6、如何选择合适的核函数和超参数来构建SVM模型?

选择合适的核函数和超参数来构建支持向量机(SVM)模型通常需要一定的经验和实验。以下是一般的步骤和一些Python示例代码。

1、数据准备:

- 首先,需要准备好数据集,包括特征和标签。

2、划分数据集:

- 将数据集分为训练集和测试集,以便评估模型的性能。

3、选择核函数:

- SVM的性能与核函数的选择密切相关。常见的核函数包括线性核、多项式核和径向基函数(RBF)核。选择核函数的一种方法是尝试不同的核函数,并比较它们的性能。以下是一个示例:

from sklearn import svm

# 使用线性核

linear_svm = svm.SVC(kernel='linear')

# 使用多项式核

poly_svm = svm.SVC(kernel='poly', degree=3) # 可以调整多项式的阶数

# 使用RBF核

rbf_svm = svm.SVC(kernel='rbf')

4、选择超参数:

- SVM还有一些超参数需要调整,例如正则化参数C、多项式核的阶数、RBF核的γ等。通常使用交叉验证来选择合适的超参数。以下是一个示例:

from sklearn.model_selection import GridSearchCV

# 定义超参数搜索范围

param_grid = {'C': [0.1, 1, 10],

'gamma': [0.001, 0.01, 0.1, 1]}

# 创建SVM模型

svm_model = svm.SVC(kernel='rbf')

# 使用网格搜索来选择最佳超参数

grid_search = GridSearchCV(svm_model, param_grid, cv=5)

grid_search.fit(X_train, y_train)

# 输出最佳超参数

best_params = grid_search.best_params_

print("Best Hyperparameters:", best_params)

5、模型评估:

- 在测试集上评估模型的性能,可以使用准确度、精确度、召回率等指标来评估模型。

6、可视化决策边界:

- 对于二维数据,可以绘制决策边界来可视化模型的分类结果。

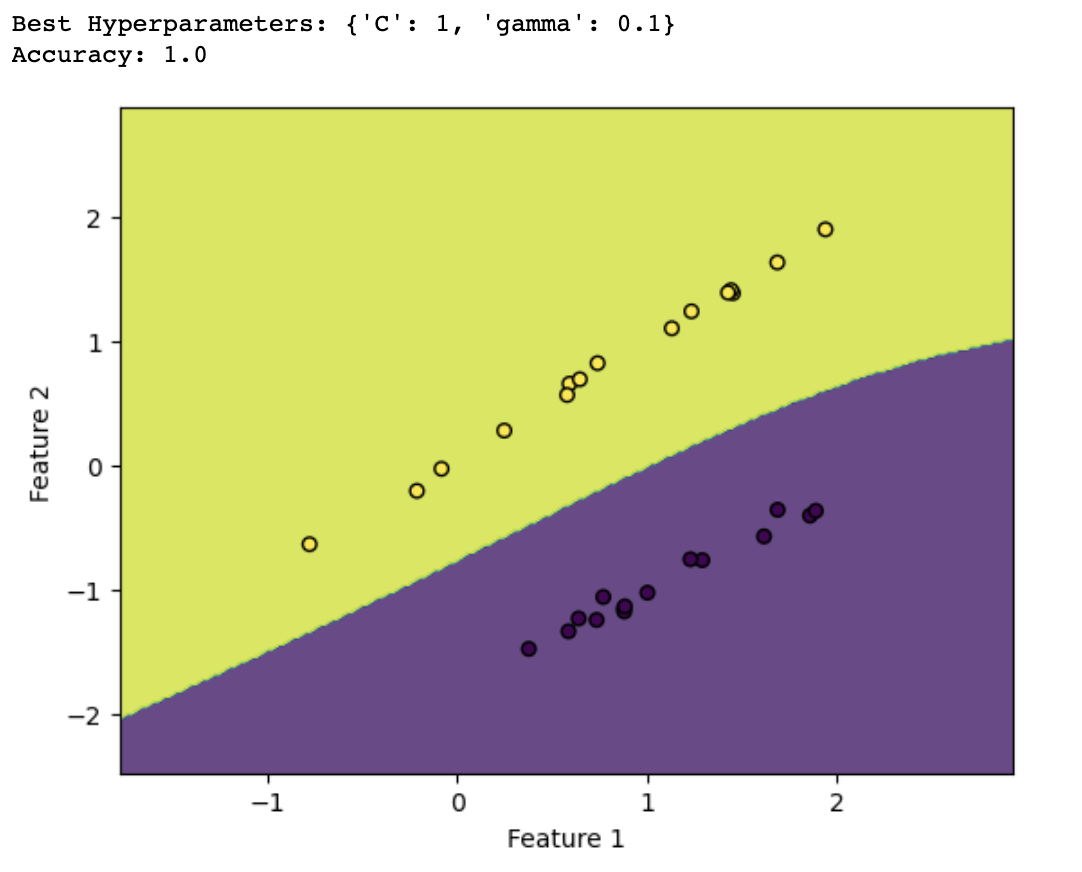

以下是一个完整的Python示例代码,演示了上述步骤:

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn import svm

from sklearn.model_selection import GridSearchCV

# 生成示例数据

X, y = datasets.make_classification(n_samples=100, n_features=2, n_classes=2, n_clusters_per_class=1, n_redundant=0, random_state=42)

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 定义超参数搜索范围

param_grid = {'C': [0.1, 1, 10],

'gamma': [0.001, 0.01, 0.1, 1]}

# 创建SVM模型

svm_model = svm.SVC(kernel='rbf')

# 使用网格搜索来选择最佳超参数

grid_search = GridSearchCV(svm_model, param_grid, cv=5)

grid_search.fit(X_train, y_train)

# 输出最佳超参数

best_params = grid_search.best_params_

print("Best Hyperparameters:", best_params)

# 训练最佳模型

best_svm_model = svm.SVC(kernel='rbf', C=best_params['C'], gamma=best_params['gamma'])

best_svm_model.fit(X_train, y_train)

# 在测试集上评估模型性能

accuracy = best_svm_model.score(X_test, y_test)

print("Accuracy:", accuracy)

# 绘制决策边界

def plot_decision_boundary(model, X, y):

h = 0.02 # 步长

x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1

xx, yy = np.meshgrid(np.arange(x_min, x_max, h), np.arange(y_min, y_max, h))

Z = model.predict(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

plt.contourf(xx, yy, Z, alpha=0.8)

plt.scatter(X[:, 0], X[:, 1], c=y, edgecolors='k', s=30)

plt.xlabel("Feature 1")

plt.ylabel("Feature 2")

plt.show()

# 绘制决策边界

plot_decision_boundary(best_svm_model, X_test, y_test)

这个示例代码涵盖了选择核函数和超参数以及模型评估的基本步骤,并通过决策边界可视化模型的分类结果。可以根据自己的数据和问题来调整这些步骤以获得最佳的SVM模型。

7、什么是多类别分类问题,SVM如何处理这类问题?

多类别分类问题是指需要将数据分成多个不同类别或标签的问题,而不仅仅是两个类别(二分类问题)。

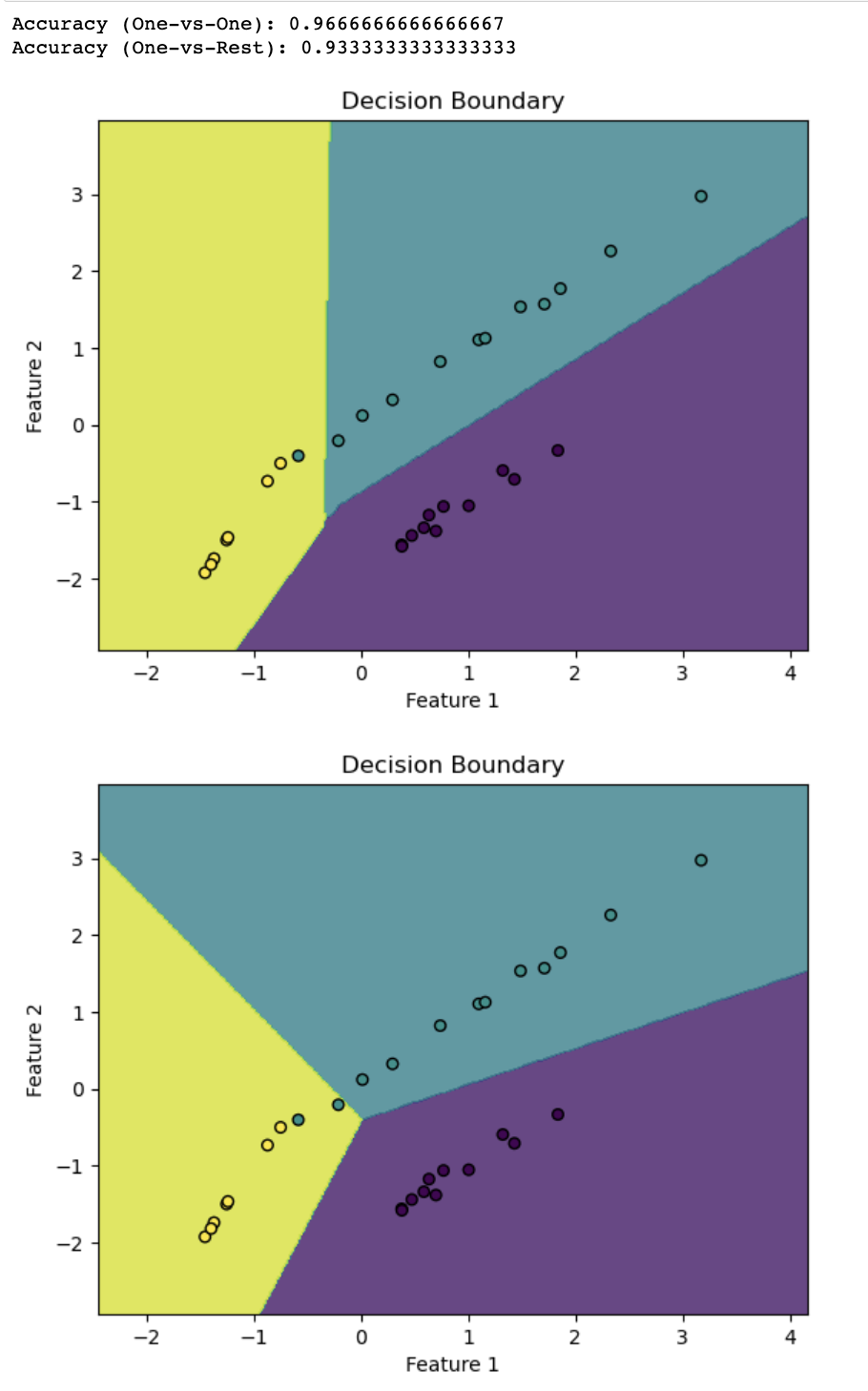

支持向量机(SVM)通常是用于二分类问题的,但可以通过不同的策略来处理多类别分类问题。一种常用的方法是一对一(One-vs-One)和一对多(One-vs-Rest或One-vs-All)策略。

- 一对一策略:在这种策略下,对于有K个类别的问题,我们构建K(K-1)/2个二分类SVM模型,每个模型解决两个类别之间的问题。然后,通过投票或其他组合方法将这些二分类器的结果合并成一个多类别分类器。

- 一对多策略:在这种策略下,对于有K个类别的问题,我们构建K个二分类SVM模型,每个模型将一个类别与其他所有类别进行区分。然后,通过选择具有最高置信度的分类器来决定样本的最终类别。

以下的Python示例,演示如何使用一对一策略和一对多策略来处理多类别分类问题,并可视化决策边界:

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn import svm

# 生成示例数据

X, y = datasets.make_classification(n_samples=100, n_features=2, n_classes=3, n_clusters_per_class=1, n_redundant=0, random_state=42)

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 使用一对一策略

from sklearn.multiclass import OneVsOneClassifier

ovo_svm = OneVsOneClassifier(svm.SVC(kernel='linear'))

ovo_svm.fit(X_train, y_train)

accuracy_ovo = ovo_svm.score(X_test, y_test)

print("Accuracy (One-vs-One):", accuracy_ovo)

# 使用一对多策略

from sklearn.multiclass import OneVsRestClassifier

ova_svm = OneVsRestClassifier(svm.SVC(kernel='linear'))

ova_svm.fit(X_train, y_train)

accuracy_ova = ova_svm.score(X_test, y_test)

print("Accuracy (One-vs-Rest):", accuracy_ova)

# 绘制决策边界

def plot_decision_boundary(model, X, y):

h = 0.02 # 步长

x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1

xx, yy = np.meshgrid(np.arange(x_min, x_max, h), np.arange(y_min, y_max, h))

Z = model.predict(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

plt.contourf(xx, yy, Z, alpha=0.8)

plt.scatter(X[:, 0], X[:, 1], c=y, edgecolors='k', s=30)

plt.xlabel("Feature 1")

plt.ylabel("Feature 2")

plt.title("Decision Boundary")

plt.show()

# 绘制决策边界(One-vs-One)

plot_decision_boundary(ovo_svm, X_test, y_test)

# 绘制决策边界(One-vs-Rest)

plot_decision_boundary(ova_svm, X_test, y_test)

代码演示了使用一对一和一对多策略来处理多类别分类问题,并通过可视化决策边界展示了两种策略的效果。

在实际应用中,可以根据数据和问题选择合适的策略来解决多类别分类问题。

8、SVM与逻辑回归(Logistic Regression)之间有哪些相似之处和差异?

支持向量机和逻辑回归(Logistic Regression)是两种不同的机器学习算法,用于分类和回归任务。

它们有一些相似之处,也有一些显著的差异。下面是它们之间的相似之处和差异:

相似之处

1、用途:

- 相似之处:SVM和逻辑回归都可以用于二元分类问题,也可以扩展到多类别分类。

2、线性模型:

- 相似之处:SVM和逻辑回归都是线性模型,它们尝试在特征空间中找到一个线性决策边界来分离不同类别的数据点。

差异

1、损失函数:

- 差异:逻辑回归使用对数损失函数,而SVM使用合页损失函数(Hinge Loss)。这导致了它们在优化和预测时的不同行为。

2、决策边界:

- 差异:SVM的目标是找到离决策边界最近的数据点(支持向量),而逻辑回归的目标是找到最大似然估计下的决策边界。因此,SVM更加关注支持向量,而逻辑回归更加关注整体数据点的概率分布。

3、鲁棒性:

- 差异:SVM通常对异常值更加鲁棒,因为它最大化了离决策边界最近的数据点的间隔。逻辑回归对异常值更加敏感,因为它使用了对数损失函数。

4、参数调整:

- 差异:SVM的性能高度依赖于核函数的选择,而逻辑回归相对较少需要参数调整。

下面是一个示意图,用于说明SVM和逻辑回归在二元分类问题上的决策边界和支持向量的不同行为:

比如上图中,左边是SVM的决策边界,右边是逻辑回归的决策边界。SVM的决策边界受支持向量的影响,这些支持向量是距离决策边界最近的数据点。逻辑回归的决策边界受所有数据点的影响,并且以概率分布方式建模。这个示意图突出了它们之间的差异,以及SVM更关注离决策边界最近的数据点,而逻辑回归更关注整体数据点的概率分布。

9、在大规模数据集上如何加速SVM的训练过程?谈谈支持向量机的可扩展性。

支持向量机(Support Vector Machine,SVM)是一种强大的监督学习算法,可以用于分类和回归任务。在大规模数据集上训练SVM模型可能会变得非常耗时,但有一些方法可以加速其训练过程并提高可扩展性:

1、特征选择和降维:在大规模数据集上,可以通过选择最重要的特征或者使用降维技术(如主成分分析)来减小数据的维度。减小特征空间可以大幅降低模型的复杂性,从而提高训练速度。

2、随机子样本:可以考虑使用随机子样本来代替整个数据集进行训练。这种方法被称为随机梯度下降(Stochastic Gradient Descent,SGD),它在每个训练迭代中仅使用部分数据,从而加速了训练过程。这对于大规模数据集通常效果很好。

3、核技巧的近似方法: SVM中的核技巧(kernel trick)可以将低维特征映射到高维空间,但计算复杂度高。可以使用近似方法,如随机四元数化(Random Fourier Features)或Nystrom方法,来加速核矩阵的计算,从而减少训练时间。

4、并行化和分布式计算: 在大规模数据集上,可以利用并行计算或分布式计算框架来加速SVM的训练。这允许多个计算单元同时处理不同的数据批次或模型参数。

5、缩放到更小的问题: 将大规模数据集分成多个较小的子问题进行训练,然后将它们组合起来。这种方法通常用于分布式SVM训练。

6、使用线性SVM或线性核: 如果问题允许,考虑使用线性SVM或线性核,因为它们的训练速度通常比非线性SVM更快。

7、软件工具和库: 使用经过优化的SVM库和工具,如LIBSVM、Scikit-learn等,它们通常已经实现了一些优化策略来提高可扩展性和训练速度。

支持向量机的可扩展性受到多个因素的影响,包括数据集的大小、特征维度、核函数的复杂性以及计算硬件的性能。上述提到的方法可以帮助提高SVM在大规模数据集上的可扩展性,但在某些极端情况下,仍然可能面临性能问题。

因此,在实际应用中,需要综合考虑问题的复杂性和可用资源来选择合适的方法以加速SVM的训练过程。

10、SVM有什么局限性和适用性条件?在什么情况下它可能不适用?

支持向量机(SVM)是一个强大的机器学习算法,但它也有一些局限性和适用性条件。以下是一些常见的局限性和适用性条件:

1. 高维问题:在高维空间中,SVM的性能可能会下降,因为数据在高维空间中更容易出现过拟合问题,而且计算复杂度也会增加。在高维问题中,选择适当的核函数和正则化参数非常重要。

2. 大规模数据集:在大规模数据集上,SVM的训练时间可能会很长,特别是对于非线性SVM或具有复杂核函数的SVM。针对大规模数据集的训练方法需要特别注意。

3. 选择适当的核函数:选择合适的核函数是关键,但并不总是容易。核函数的选择可能需要领域知识或者交叉验证等技术来进行调优。错误的核函数选择可能导致模型性能下降。

4. 不适用于大量噪声数据:SVM对噪声数据敏感,特别是在训练数据中存在大量噪声或异常值时。需要在数据预处理中处理噪声或异常值。

5. 不适用于非平衡数据集:当类别不平衡且一个类别的样本数量远远超过另一个类别时,SVM可能会倾向于支持样本数量更多的类别,而忽略样本数量较少的类别。在这种情况下,需要采取类别平衡的策略,如过采样或欠采样。

6. 需要调整超参数:SVM的性能高度依赖于正则化参数和核函数的选择,这些超参数需要仔细调整。通常需要进行交叉验证来找到最佳的超参数设置。

7. 不适用于大规模多类别分类问题:SVM在处理大规模多类别分类问题时可能变得非常复杂。针对此类问题通常有更适合的算法,如深度学习模型。

SVM 适用于许多分类和回归问题,尤其在中小规模数据集上表现出色。

然而,它并不是适用于所有情况的通用解决方案,特别是在处理大规模高维数据集、非平衡数据集或多类别问题时,需要仔细考虑其局限性和适用性条件,并根据具体情况选择合适的算法。

评论(1)